GitHub Copilot reforça segurança com princípios para IA

GitHub Copilot acaba de detalhar um conjunto de princípios de segurança que limitam a autonomia dos seus agentes de inteligência artificial, apostando em revisão humana, firewall de rede e distribuição controlada de permissões para proteger repositórios corporativos e pessoais.

Riscos mapeados: exfiltração, impersonação e injeção

Segundo o engenheiro Rahul Zhade, três vetores principais motivaram as novas diretrizes. O primeiro é a exfiltração de dados: com acesso à internet, um agente pode ser induzido a enviar tokens ou código confidencial para um site mal-intencionado. O segundo é a impersonação. Quando um bot cria pull requests ou comenta em issues, surge a dúvida de quem autorizou a ação e sob quais permissões. Por fim, há o risco de prompt injection, em que instruções ocultas em texto invisível ou trechos de código manipulam a IA a executar tarefas não desejadas.

Camadas de proteção: firewall, revisão humana e limites de contexto

Para mitigar esses riscos, o Copilot adota medidas práticas. Um firewall nativo restringe o tráfego de rede dos agentes, bloqueando domínios desconhecidos e permitindo apenas endereços aprovados pelo usuário. Além disso, toda ação potencialmente destrutiva passa por um humano no circuito: o agente cria pull requests, mas nunca faz push direto em branch principal nem dispara pipelines de CI automaticamente; o mantenedor precisa revisar e aprovar.

Outro ponto crítico é a limitação de contexto. O Copilot recebe apenas os arquivos estritamente necessários para cumprir a tarefa e exclui segredos de CI, chaves de acesso e diretórios externos. Tokens usados durante a sessão são revogados assim que o agente termina o trabalho. Para evitar instruções ocultas, o sistema remove caracteres Unicode invisíveis e mostra ao usuário todos os trechos de texto que alimentam o modelo.

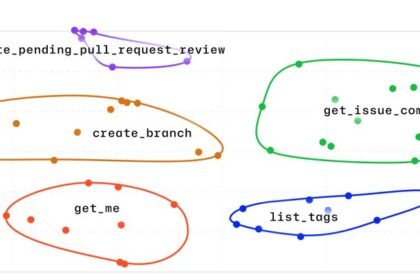

Atribuição clara e permissões granuladas

Cada interação é registrada com autoria dupla: o usuário que iniciou a ação e o próprio Copilot. Pull requests, por exemplo, levam assinatura conjunta, facilitando auditoria e rastreabilidade. Além disso, apenas colaboradores com permissão write podem atribuir o agente a uma issue, e ele lê comentários somente de quem também possui esse nível de acesso—um reforço extra para repositórios públicos.

Imagem: Internet

Com esses princípios, a Microsoft tenta equilibrar velocidade de desenvolvimento e segurança, modelo já citado por veículos especializados como The Verge. A empresa afirma que as regras valem para todas as experiências agentic, do Copilot Chat ao novo coding agent.

Se você quer manter seu ambiente de trabalho tão protegido quanto seu código, visite nosso portal e confira outros guias sobre produtividade e segurança. Para mais dicas de setup profissional, continue acompanhando nossa editoria.

Crédito da imagem: GitHub Fonte: GitHub